Meta推出了一个名为“Sapiens”的全新AI模型,专注于分析包含人类的图像。

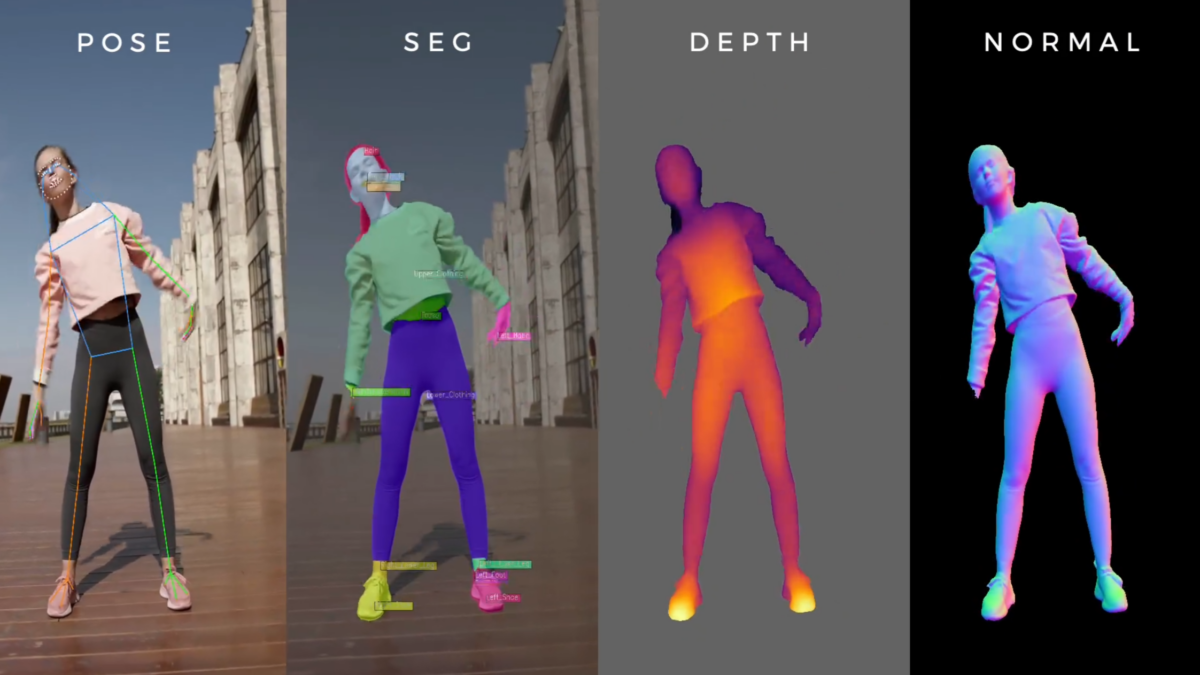

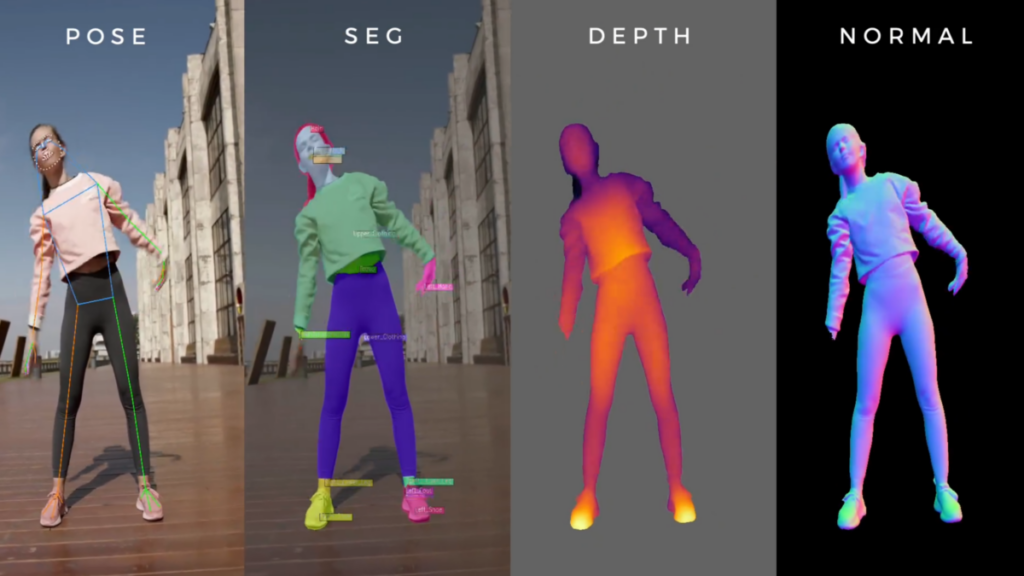

这些模型在一个包含3亿张人类图像的数据集上进行了预训练,能够执行各种任务,包括2D姿势估计、身体分割、深度估计和表面法线估计。后者用于确定图像中每个点的三维空间中表面的方向。这一信息对于理解图像中物体和人物的三维结构至关重要,并在创建现实光照效果的三维重建中扮演关键角色。

Meta表示,Sapiens模型在这些任务中的表现显著优于现有方法。例如,在身体分割任务中,该任务识别图像中的个体身体部位,Sapiens 2B模型在这一任务中的表现比之前的方法提高了超过17个百分点。

研究人员指出,模型的性能随着规模的增加而提高:最大的模型Sapiens-2B具有20亿个参数,并且在1024×1024像素的图像分辨率下进行本地训练。Meta声称,这使得Sapiens-2B能够比传统低分辨率模型进行更详细的分析。

Sapiens模型可能提升数据集质量

研究人员认为,在大规模精心策划的人体图像数据集上进行预训练是Sapiens模型性能的关键因素。这使得模型在真实场景中的泛化能力优于通常训练于普通图像数据的方法,例如Meta的Segment Anything 2系统。

尽管性能有所提升,团队承认在处理复杂姿势、拥挤场景和严重遮挡时仍面临挑战。团队表示,Sapiens模型还可以作为标注大量现实数据的工具,为下一代以人为中心的图像分析系统的发展提供支持。

Meta已在GitHub上向研究社区开放了Sapiens模型。