近年来,文本到图像生成的研究进展非常迅速,一系列重大突破为其相关领域带来了新机遇与发展方向。特别是文本指导图像编辑(TGIE)是一个目前实用且具有广阔前景的研究方向。它需要对现有的生成图像或拍摄照片进行编辑调整,而非完全重新创建视觉效果。这在重新创建视觉效果时间成本高或不可行的情况下,提供了一种快速便捷的解决方案。

谷歌顺势而为,于近日提出了Imagen Editor和EditBench 两个概念方法:

Imagen Editor是一种Masked inpainting(掩码修补)任务的最先进解决方案。在这个任务中,用户会在一幅图像上提供文本说明,并在绘图界面生成的mask(掩码)指示他希望修改的图像区域。Imagen Editor能够根据用户的文本说明,在现有图片基础上进行二次创作。

EditBench是一种评估图像编辑模型质量的新方法。它超越了现有方法中粗略的“图像是否符合文本说明”评价标准,可以对模型在不同属性、对象与场景方面进行更加细致的性能评估。特别是,这个方法注重考察图像与文本说明之间的一致性,同时也关注生成图像本身的质量。

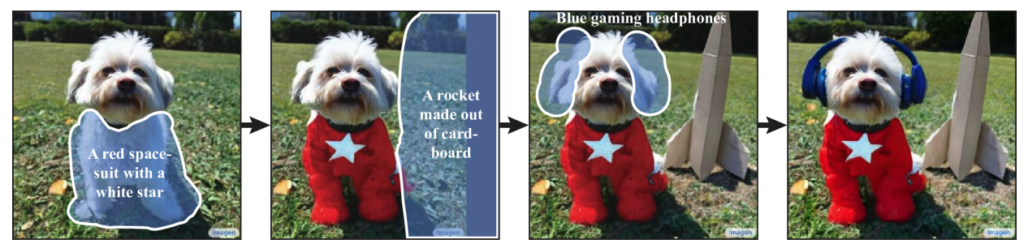

谷歌官方提供的一个例子,先是高亮宠物狗的身体,然后输入“带有白色星星的红色宇航服”,在背景中显示用纸板制成的火箭,最后是让宠物狗戴上蓝色蓝牙耳机。

Imagen Editor

Imagen Editor是一个基于Imagen微调的扩散模型,目的是改进语言输入的表征,实现细致控制与高保真输出。它需要三个输入:

1)待编辑图像

2)二值掩码:指定编辑区域

3)文本提示:上述三个输入都指导输出结果

Imagen Editor依赖三个核心技术来实现高质量的文本指导图像修补:

首先,不同于先前的修补模型使用随机框选与笔画掩码,Imagen Editor采用对象检测器掩码策略。其对象检测器模块在训练期间产生对象掩码。对象掩码基于检测对象而非随机修补,可以在文本提示与掩码区域实现更加原则的对齐。这有助于模型避免当掩码区域很小或只部分覆盖对象时文本提示被忽略的问题。

其次,Imagen Editor在训练和推理期间都采用双向注意力机制。这有助于模型建立文本提示与图像特征之间的对应关系,产生更加准确的输出结果。双向注意力允许模型同时考虑语言上下文和视觉上下文,在图像与文本注意域之间实现信息交换,获得全局上下文信息。

最后,Imagen Editor利用可控的语言指导,通过prompt tuning实现对不同文本输入的适应。这使得Imagen Editor可以根据不同的编辑指令产生相应的输出,具有较强的灵活性与泛化能力。prompt tuning实质上是一种Meta学习,可以根据语言输入动态调整参数,实现对新数据的快速适应。

EditBench

EditBench数据集用于评估文本指导图像修补模型,包含240幅图像,其中120幅为生成图像,120幅为自然图像。生成图像由Parti生成,自然图像来自Visual Genome与Open Images数据集。EditBench涉及不同的语言输入、图像类型与文本提示的具体程度,包括简单提示、丰富提示与完整图像描述。每个示例都包含:

1)遮罩输入图像

2)输入文本提示

3)高质量输出图像,作为自动度量的参考

为了洞察不同模型的相对优势与劣势,EditBench在三个类别设计了细致的文本提示:

1)属性:如材质、颜色、形状、大小、数量等

2)对象类型:如常见对象、罕见对象、文本渲染等

3)场景:如室内、室外、真实场景或绘画等

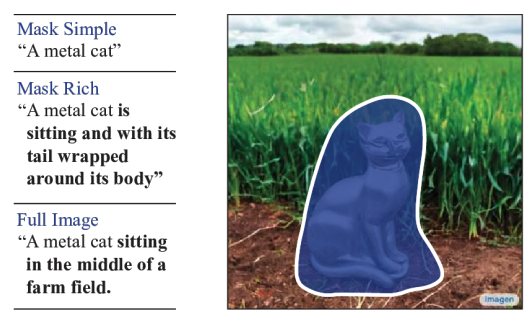

为了理解不同的文本提示对模型性能的影响,EditBench提供三种文本提示类型:

1)单属性提示(Mask Simple):描述遮罩对象的一个属性

2)多属性提示(Mask Rich):描述遮罩对象的多个属性,考察模型处理复杂属性绑定与包含的能力

3)完整图像描述(Full Image):描述整个图像

这是一个全新的用于评估图像修补模型的高质量数据集。它在数据类型的选择、语言输入的设置与性能考察层面上都进行了精心设置。

最后,谷歌表示作为负责任的公司,安全问题上目前尚未完全做好准备,暂时不会向公众发布 Imagen Editor。